Em nossos artigos anteriores, exploramos os temas “Entendendo a Inteligência Artificial de forma simples” e “Aprendizagem de Máquina”. Hoje, vamos mergulhar no universo dos “Transformers”, uma inovação revolucionária no campo da Inteligência Artificial.

No campo da inteligência artificial existem vários ramos de pesquisa, um deles é o processamento de linguagem natural, cuja sigla em inglês é NLP. Um dos problemas mais notórios do NLP é o problema da tradução de texto de uma língua para a outra. Traduzir um texto não é tarefa simples, pois não se trata somente de converter palavra por palavra, é necessário levar em conta o contexto do que está escrito. É nesse cenário que entra em campo a Inteligência Artificial, como uma técnica de realizar processamento de texto de forma inteligente, que não fique preso às regras criadas manualmente, mas sim aprenda as regras do zero.

Antes dos Transformers, o modelo dominante para lidar com dados textuais era o “Long short-term memory” (LSTM), ou “memória de curto e longo prazo”. O LSTM foi projetado para compreender sequências longas de texto e capturar padrões esparsos. No entanto, ele enfrentava um desafio significativo: não conseguia manter uma estabilidade a longo prazo à medida que o número de palavras aumentava. Isso ocorre porque o LSTM tem uma capacidade finita de representação abstrata do conteúdo do texto.

https://projectgurukul.org/automatic-music-generation-lstm

O LSTM é um tipo de inteligência artificial que é capaz de “aprender” e “lembrar” informações ao longo de sequências de dados, como uma frase ou um parágrafo. A arquitetura do LSTM é composta por uma série de células de memória que são capazes de manter um estado ao longo do tempo.

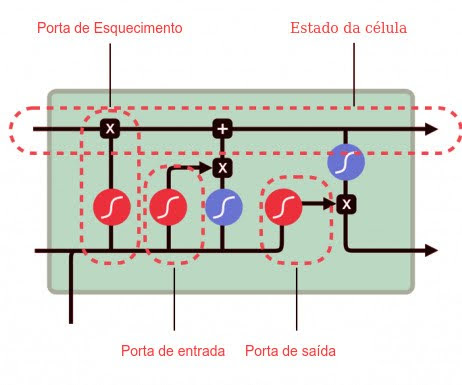

Cada célula de memória no LSTM tem quatro componentes principais: uma porta de entrada, uma porta de esquecimento, uma porta de saída e um estado da célula, que é uma representação abstrata do texto:

- A porta de entrada decide quais informações novas serão armazenadas na célula de memória.

- A porta de esquecimento decide quais informações antigas serão descartadas.

- A porta de saída decide quais informações da célula de memória serão usadas na saída da célula.

- O estado da célula é uma representação abstrata do que está escrito no texto, a cada palavra esse estado é atualizado.

Essas portas permitem que o LSTM decida quais informações são importantes para manter ou descartar à medida que processa cada palavra em uma sequência de texto. Isso permite que o LSTM capture efetivamente informações contextuais e dependências de longo prazo em sequências de texto.

No entanto, como mencionado anteriormente, o LSTM tem uma capacidade limitada de representação abstrata do conteúdo do texto, devido a ter um tamanho prefixado de suas estruturas, o que pode ser um desafio ao lidar com sequências de texto muito longas, na ordem de páginas de tamanho.

Os Transformers:

Os Transformers, introduzidos pela Google em 2017, foram projetados para aprimorar a capacidade dos modelos de Inteligência Artificial de reconhecer padrões textuais esparsos. Eles foram desenvolvidos para identificar e entender padrões que são raros e estão dispersos ao longo de um texto.

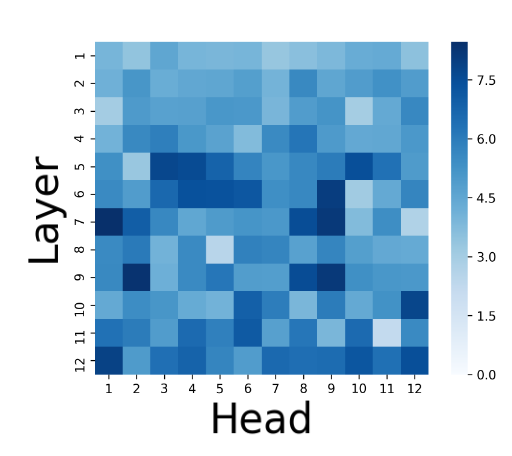

Para superar a limitação do LSTM, os Transformers propõem o uso de um mecanismo chamado “Attention”, ou “Atenção”. Este mecanismo permite que o Transformer de diferentes pesos a diferentes palavras em uma frase, dependendo de sua importância relativa no contexto. Em tese não existem limites para quantas palavras esse mecanismo pode processar ao mesmo tempo, isso confere ao modelo uma capacidade de representação ilimitada, permitindo-lhe capturar dependências de longo alcance e nuances contextuais de maneira mais eficaz.

No entanto, essa capacidade vem com um custo: o consumo de memória dos Transformers aumenta quadraticamente à medida que o número de palavras aumenta. Para entender melhor, imagine uma frase com 10 palavras. O mecanismo de atenção criará uma tabela de tamanho 10 x 10, ou seja, 100 posições. Se tivermos um texto com 100 palavras, o mecanismo de atenção terá 100 x 100 posições, ou seja, 10 Mil elementos. E esse número continua crescendo quadraticamente à medida que o número de palavras aumenta. Na prática, isso limitou o uso do Transformer clássico a pequenas porções de texto (até 2023 o chatGPT contava com uma capacidade de processar aproximadamente 40 páginas de texto, ou cerca de 12 mil palavras). Esse conceito é conhecido como “Context Window” ou “Janela de Contexto”. De toda forma, a disponibilidade de memória tem se tornado cada vez mais barata ao longo dos anos.

[Attention is Not Only a Weight: Analyzing Transformers with Vector Norms](https://aclanthology.org/2020.emnlp-main.574) (Kobayashi et al., EMNLP 2020)

Apesar dessa limitação, os Transformers revolucionaram o campo da Inteligência Artificial e são amplamente utilizados em uma variedade de aplicações práticas. Eles são especialmente úteis em tarefas que envolvem o processamento de linguagem natural, como tradução automática, geração de texto e análise de sentimentos.

Um dos exemplos mais notórios do uso dos Transformers é a ChatGPT. O GPT do nome significa em português “Transformador Generativo Pré-treinado”. Este modelo foi treinado em uma grande quantidade de texto e é capaz de gerar respostas coerentes e contextualmente relevantes a uma variedade de entradas, tornando-o uma ferramenta poderosa para uma série de aplicações, desde assistentes virtuais até ferramentas de redação assistida.

Entretanto NLP não é a única área de aplicação dos Transformers, em 2020, também o Google, propôs uma técnica para aplicar a capacidade dos Transformers para analisar imagens, utilizando uma técnica para transformar cada pedaço da imagem em uma espécie de palavra, e assim utilizar a mesma ideia do Attention.

Atualmente os transformers estão sendo usados em todo tipo de aplicações, desde análise de texto, geração de vídeos e até mesmo previsão climática.