Aurélio Miranda, cientista de dados da Norven, explica de forma prática sobre a ferramenta de predição de Baixas, que foi Finalistas do Prêmio Nacional de Gestão de Ativos 2022

EMPRESAS: Enel e Norven

Resumo

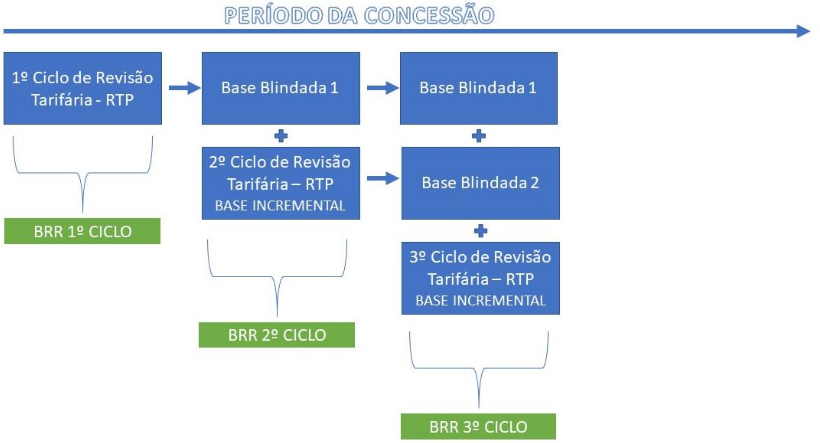

A Agência Nacional de Energia Elétrica – ANEEL, autarquia em regime especial vinculado ao Ministério de Minas e Energia, é a responsável pela regulação e fiscalização dos ativos em posse das concessões de geração, transmissão e distribuição de energia elétrica espalhadas pelo Brasil. Na legislação vigente, as distribuidoras de energia elétrica devem apresentar a cada Ciclo de Revisão Tarifária Periódica – (CRTP) – que pode variar entre 3 e 5 anos – o resultado da avaliação do seu ativo imobilizado em serviço. Esta avaliação é uma das partes que fixa o valor da tarifa de energia elétrica para o consumidor final, que após fiscalizada e homologada pela ANEEL é gerada uma “Base Blindada” do ativo da concessionária.

O controle deste ativo fixo é regulado pela ANEEL devendo as concessionárias seguir os parâmetros de imobilização, depreciação e movimentação do ativo conforme os manuais vigentes. Da mesma forma que há a instalação de novos ativos, existem ativos contabilizados que se deterioram ao longo do tempo, por desgaste natural ou sinistro, e que já possuem a efetiva correspondência contábil no controle patrimonial da concessionária. Para estes ativos já registrados na contabilidade, que houve a constatação da efetiva retirada de operação, a concessionária deverá proceder a baixa do equipamento.

Para a maior parte das concessionárias, este processo de retirada do equipamento de operação e a respectiva vinculação da baixa com a Base Blindada é uma incógnita, pois o impacto econômico-financeiro só será conhecido no momento da revisão do ciclo tarifário.

Em busca de afastar essa incógnita e gerar projeções mais assertivas, a ferramenta sistêmica de MODELO ESTATÍSTICO DE PREDIÇÃO DE BAIXAS foi desenvolvida para projetar com maior confiabilidade o impacto financeiro ocasionado pela baixa de equipamento.

Nesta modelagem, somente com o quantitativo projetado pela área técnica de equipamento a ser retirado de operação, é possível projetar o impacto financeiro na Base Blindada, mensurando o Valor Novo de Reposição – VNR e o Valor de Mercado em Uso – VMU a ser subtraído da base.

1. INTRODUÇÃO

A Agência Nacional de Energia Elétrica – ANEEL, em sua missão institucional, vem atualizando, ao longo do tempo, com a participação da sociedade, os procedimentos de controle patrimonial utilizados pelas concessionárias, permissionárias e autorizadas de energia elétrica, para registro de suas operações de cadastro, movimentação de bens e instalações que compõem o patrimônio do serviço concedido, sujeitos à reversão, de forma a possibilitar o efetivo exercício das atribuições de regulação e fiscalização estabelecidas pela legislação aplicável aos concessionários outorgados para realização de serviços ligados a energia elétrica.

A revisão das tarifas dos serviços públicos concedidos é uma exigência legal, conforme dispõe o art. 9º da Lei nº 8.987/1995 (Lei de Concessões), complementado pelo art. 10 da mesma Lei. Tais dispositivos foram incorporados aos contratos de concessão dos serviços de distribuição de energia elétrica, o que confere à revisão tarifária das concessionárias um caráter de obrigação contratual.

Assim, cabe ao órgão regulador atuar, na forma da lei e do contrato, nos processos de definição e controle dos preços e tarifas, homologando seus valores iniciais, reajustes e revisões, e criar mecanismos de acompanhamento de preços, conforme inciso X, do art. 4º, do Anexo I, do Decreto nº 2.335/1997.

Com base na lei das concessões e dispositivos contratuais a ANEEL estabeleceu em um conjunto de módulos de Procedimentos de Regulação Tarifária – PRORET, as tratativas de regulação dos bens e instalações que compõem o patrimônio do serviço concedido.

O PRORET em conjunto com as demais normas vigentes, como o Manual de Contabilidade do Setor Elétrico – MCSE, o Manual de Controle Patrimonial do Setor Elétrico – MCPSE entre outros estabelece metodologia, critérios e diretrizes que as concessionárias devem atender ao longo do seu contrato de concessão.

2. DEFINIÇÃO PRORET

Em seu módulo 2: Revisão Tarifária Periódica de Concessionárias de Distribuição, Submódulo 2.3 – Base de Remuneração Regulatória, homologado pela Resolução Normativa Nº 686 de 23 de novembro de 2015, estabelece a metodologia a ser utilizada para a definição da Base de Remuneração Regulatória – BRR nos processos de Revisão Tarifária Regulatória – RTP.

O PRORET 2.3 estabelece que para o ativo compor a BRR, deverá atender os seguintes critérios e diretrizes:

- A base de remuneração aprovada na revisão tarifária anterior deve ser “blindada”. Como Base Blindada entende-se os valores aprovados por laudo de avaliação na última revisão tarifária, associados aos ativos existentes, em operação, excetuando-se as movimentações ocorridas (baixas, depreciação) e as respectivas atualizações, além dos valores para as contas de Almoxarifado de Operações;

- As inclusões entre as datas-bases da revisão tarifária anterior e da atual, desde que ainda em operação, compõem a Base Incremental e são avaliadas utilizando-se a metodologia definida neste Submódulo;

- Os valores finais da avaliação são obtidos somando-se os valores atualizados da base de remuneração blindada (item a) com os valores das inclusões ocorridas entre as datas-bases da revisão tarifária anterior e da atual – base incremental (item b);

- Considera-se como data-base do laudo de avaliação o último dia do sexto mês anterior ao mês da revisão tarifária da RTP;

- A base de remuneração deverá ser atualizada pela variação do IPCA, entre a data-base do laudo de avaliação e a data da revisão tarifária; (ANEEL, 2015, p. 5)

De forma resumida, todos os ativos gerados no ciclo tarifário, denominado “Base Incremental” será “Blindado” após a conclusão do processo de fiscalização e homologação pela ANEEL.

A tratativa desta base blindada deverá atender os seguintes critérios e diretrizes conforme dispostos no PRORET 2.3 item 3.2.1:

- Devem ser expurgadas da base blindada as baixas ocorridas entre as datas-bases da revisão tarifária anterior e da atual;

- Após a exclusão dessas baixas, os valores remanescentes de cada bem da base blindada devem ser atualizados, ano a ano, pela variação do IPCA;

- O valor monetário referente às Obrigações Especiais da base blindada será obtido atualizando-se o valor aprovado na revisão tarifária anterior pela variação do IPCA. Nenhum valor deverá ser deduzido das Obrigações Especiais a título de baixas efetuadas na base blindada;

- Deve ser levado em consideração o efeito da depreciação acumulada ocorrida entre as datas-bases da revisão tarifária anterior e a atual, obtendo- se o valor da base de remuneração blindada atualizada;

- Os Índices de Aproveitamentos – IA, referentes aos bens da base blindada, deverão ser revistos, conforme critérios estabelecidos neste Submódulo. (ANEEL, 2015, p. 5 e 6).

Figura 1: Eventos tarifários

Fonte: Recorte MCPSE, ANEEL

De forma esquematizada, a BRR das distribuidoras desenvolve-se por ciclos tarifários onde o investimento capitalizado em infra estrutura de distribuição deverá aguardar a data de revisão estipulada pelo regulador para de fato, gerar receita do investimento. Devido a este modelo atual de remuneração, há a necessidade de projetar o orçamento no horizonte de longo prazo onde a base blindada é o ponto de partida dos investimentos do próximo ciclo, sendo extremamente importante ter premissas de baixas factíveis.

3. DEFINIÇÃO MCPSE

Além dos critérios e diretrizes estabelecidos no PRORET 2.3, devemos buscar informações complementares no Manual de Controle Patrimonial do Setor Elétrico – MCPSE outras definições importantes para o total entendimento deste trabalho.

Os equipamentos e instalações para serem imobilizados, devem atender os critérios estabelecidos pelo MCPSE, Resolução Normativa 674 de 11 de agosto de 2015.

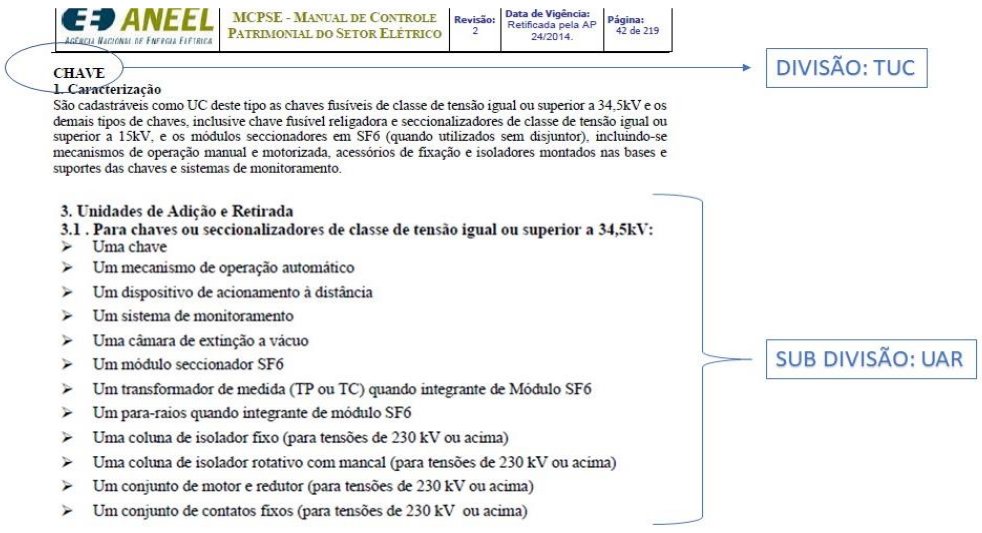

Figura 2: Exemplo MCPSE.

Fonte: Recorte MCPSE, ANEEL

No MCPSE, os ativos são dividos por famílias denominadas Tipo de Unidade de Cadastro – TUC e sub dividido em Unidade de Adição e Retirada – UAR. O MCPSE além de definir as TUC’s e UAR’s também define se o cadastramento dos equipamentos e instalações deverá ser de forma individual ou massa.

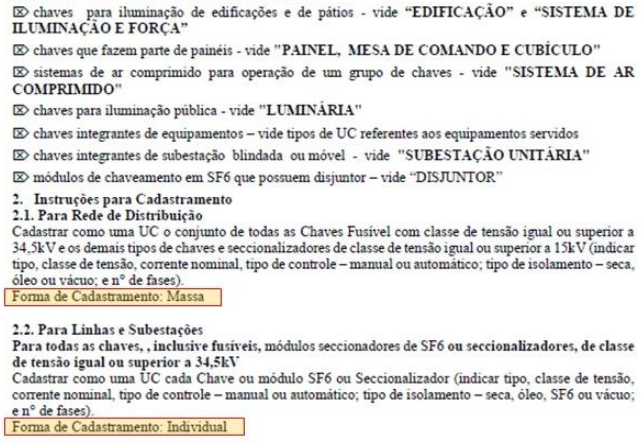

Figura 3: Detalhamento da UAR.

Fonte: Recorte MCPSE, ANEEL

O manual de controle patrimonial do setor elétrico – MCPSE (ANEEL, 2015) define:

- 7.1.1.1 – “Individual” – em que a UC se refere a um equipamento ou conjunto de equipamentos, instalação ou direito, e cujas baixas são procedidas pelos valores específicos. (ANEEL, 2015, p. 18)

- 7.1.1.2 – “Massa” – em que a UC se refere a um conjunto de equipamentos semelhantes, os quais são agrupados por data de imobilização, mensalmente, e cuja baixa dá-se pela quantidade e valor médio do mês/ano da imobilização mais antiga. No caso da concessionária ter estabelecido seus controles por município ou região, o valor médio do mês/ano poderá ser de acordo com estes controles. Em UC deste tipo, deve-se ter como norma proceder a desativação no saldo mais antigo da conta que a UC esteja classificada contabilmente respeitando-se a ODI, TUC e seus atributos (A1- A6). (ANEEL, 2015, p. 19)

Além dos critérios e diretrizes estabelecidos no PRORET 2.3, devemos buscar informações complementares no Manual de Controle Patrimonial do Setor Elétrico – MCPSE outras definições importantes para o total entendimento deste trabalho.

Os bens classificados como “individual” possibilita maior controle, já que em linhas gerais são equipamentos de pouca rotatividade como transformador de força, religador, transformador de aterramento ou por ter características de imobilidade como urbanização e benfeitoria, edificação, conduto e canaleta entre outros.

Para este grupo de ativo, na sua substituição ou troca, o MCSE exige que seja feita a desativação do mesmo imobilizado, caso contrário, nenhum outro imobilizado semelhante deverá ser desativado. Vale ressaltar que o ativo desta natureza não representa o maior grupo de investimento em uma concessionária de distribuição, representando em média 15% do total do Ativo Imobilizado em Serviço.

Os bens classificados como “massa” já apresentam maior rotatividade e tem como característica principal a mobilidade e rotatividade, podendo ser retirado de uma instalação para outra. Equipamento como medidor, poste, condutor são exemplos de bens de massa.

Para este grupo de ativo, na sua substituição ou troca, o MCSE autoriza que a desativação proceda pelo bem mais antigo da ODI e com as mesmas características técnicas conforme MCPSE. Os bens de infraestrutura de rede e medição, representam em média 85% do total do Ativo Imobilizado em Serviço de uma concessionária. Além da sua grande representatividade financeira, os bens de massa caracterizam-se pela dificuldade de controle e planejamento, já que estão mais sensíveis a sinistros e necessitam constantemente de modificações técnicas para atender as demandas de carga e confiabilidade do sistema.

4. DEFINIÇÃO DE BAIXAS

Todo bem ou instalação a serviço da concessão de distribuição de energia elétrica tem a sua correspondência contábil registrada nos controles internos da concessionária.

Todo bem ou instalação a serviço da concessão de distribuição de energia elétrica tem a sua correspondência contábil registrada nos controles internos da concessionária.

Quando ocorre a desativação do equipamento ou instalação, seja por sinistro, desgaste natural ou substituição por novas tecnologias a concessionária deverá realizar o processo de Ordem de Desativação – ODD.

A ODD é o processo de registro e acompanhamento dos custos de desativação. A ODD deve estar vinculada a uma Ordem de Imobilização – ODI existente.

Além de identificar os custos de desativação, a ODD é responsável por controlar e registrar o equipamento ou instalação foi desativado.

5. PROCESSO DE BAIXAS NA BRR

No ciclo da RTP1, todas as baixas geradas no período deverão ser refletidas na Base Blindada dos ciclos anteriores, respeitando as definições do MCPSE. As baixas afetam diretamente na renovação da rede, no planejamento do capex, no trade-off entre projetos e consequentemente na previsibilidade de valor da base de remuneração.

Para os bens individuais, a baixa deve ser exatamente o mesmo bem, respeitando o valor contabilizado, a data de imobilização e a características técnica. Caso o mesmo ativo não seja encontrado na base blindada, a baixa não deverá ser efetuada. Para os bens de massa, a baixa procederá pelo mês e ano mais antigo, respeitando as características técnicas do bem desativado. Caso o bem com a mesma característica técnica não seja encontrado na base blindada, deverá proceder a baixa por similaridade até o esgotamento total das quantidades baixadas no período.

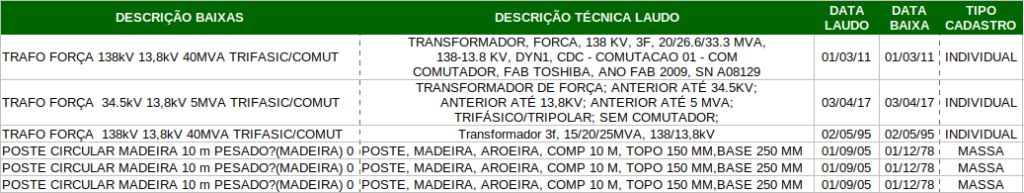

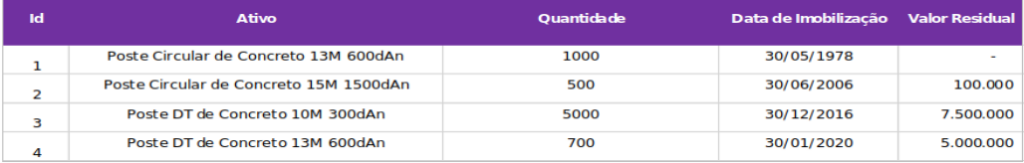

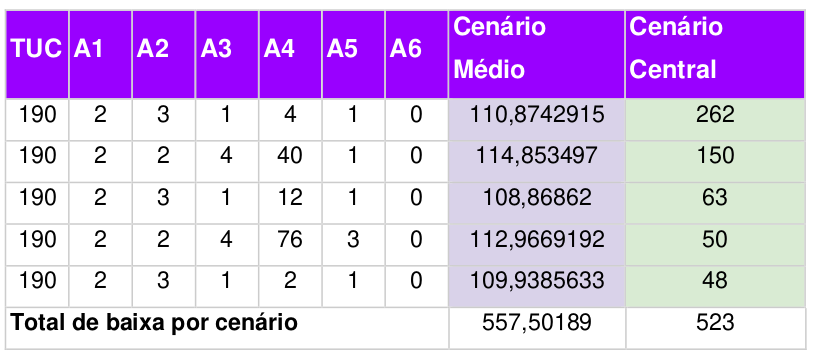

Tabela 1: Lista de UAR’s para Baixa.

Fonte: Acervo do Autor

No exemplo acima, temos a vinculação entre base blindada e baixa:

- Para o bem individual a baixa ocorre de forma exata (mesma data, características técnicas); e

- Para o bem de massa a baixa ocorre por similaridade de atributos e data mais antiga.

6. DESAFIOS

Ao longo do processo de revisão tarifária, as concessionárias enfrentam dificuldades para o processamento e mensuração do resultado das baixas, principalmente nos bens de cadastro em massa que impactam de forma significativa, já que grande parte do investimento da distribuidora ocorre neste grupo de ativos.

Buscamos um método, um algoritmo, um simulador, que nos ajude a responder os seguintes questionamentos:

- Como modelar a incerteza das baixas no negócio de distribuição?

- E se o quantitativo baixado for maior ou menor ao esperado? Qual a contribuição de uma baixa específica nas possibilidades de baixas totais?

- Posso antever meu planejamento e as tomadas de decisão no presente, dado o futuro?

Observado este cenário de incerteza dos valores a serem decrementados da Base de Remuneração Regulatória – BRR, e com a possibilidade de flexibilizar a baixa dos itens de massa, foi através simulação de múltiplos cenários, aliado com o Método de Monte Carlo e a engenharia de software que este trabalho se desenvolve.

Com essa aliança estabelecida é possível calcular qual o Impacto econômico- financeiro em trocas e substituições de ativos a partir das quantidades mensuradas pelo plano de manutenção e ou plano de modernização da concessionária, gerando informações mais assertivas para os stakeholders dos valores de decréscimo da Base de Remuneração Regulatória – BRR.

A predição do impacto das baixas no valor da BRR deverá se basear na execução do cálculo do impacto real da realização de baixas no laudo de avaliação da base blindada para múltiplos cenários, buscando uma convergência estatística para valores mais prováveis.

Ela deverá ter seu alicerce no fato de que há, para um mesmo tipo de ativos, uma grande quantidade de formas possíveis distintas de se realizarem baixas, que trarão impacto igual ou similar. Isso ocorre porque o impacto em R$ da baixa de um ativo é influenciado pelos diferentes valores unitários de avaliação deste ao longo do tempo, pelo nível de depreciação que diferentes itens do mesmo bem terão e pela quantidade ainda disponível para baixar.

A incerteza da baixa está concentrada em 2 variáveis:

- Quantitativa: Representa a incerteza quanto à quantidade total de um tipo de bem que será baixada (por exemplo, quantos postes, transformadores e medidores serão baixados nos próximos 4 anos)?

- Qualitativa: Quais as especificações dos bens que serão baixados? Ou seja, determinada a quantidade, digamos, de postes, qual será a altura, esforço e material desses postes?

Nossa metodologia parte do pressuposto que as áreas técnicas são capazes de fazer uma estimativa quantitativa razoável das baixas, mas nenhuma estimativa qualitativa. Assim, o algoritmo proposto deverá realizar a predição de um volume de baixas em torno da e

A seguir apresentamos um exemplo para melhor entendimento dessas questões, principalmente no que diz respeito a algumas regras de controle patrimonial:

Tabela 2: Lista de itens a serem baixados.

Fonte: Acervo do Autor

Suponhamos que esses sejam todos os postes avaliados na base blindada de uma (pequena) distribuidora. Conforme regras de cadastro patrimonial do setor elétrico (ref. Res. 674 – MCPSE), os bens de massa devem ser controlados por suas especificações técnicas e data de imobilização.

O ativo 1, portanto são postes Circ. 13/600, muito antigos e, portanto, totalmente depreciados. O ativo 4 são, igualmente, postes Circ. 13/600, mas esse mais novo e, portanto, com expressivo valor residual.

A regra contábil também estabelece que, obedecidas as características técnicas, os bens devem ser baixados sempre priorizando os mais antigos. Nesse exemplo, caso essa empresa realize a baixa de 1.200 postes Circ. 13/600, deverão necessariamente ser baixados as 1.000 unidades do ativo 1 (sem impacto) e mais 200 unidades do ativo 4 (impacto de R $1.428.571). A questão a ser resolvida aqui é:

Sabendo que a empresa baixará aproximadamente 700 postes até a próxima revisão tarifária, qual deverá ser o impacto em R$ proveniente dessas baixas a ser considerado na projeção de BRR que fazemos hoje?

Responder a essa questão consiste basicamente em avaliar todas as formas possíveis de fazer essas baixas, considerando também que a quantidade de 700 pode sofrer alguma alteração para mais ou para menos. Isso significa que, além de todas as combinações possíveis de baixar aproximadamente 700 postes entre os 4 ativos de poste disponíveis.

REFLEXÃO:

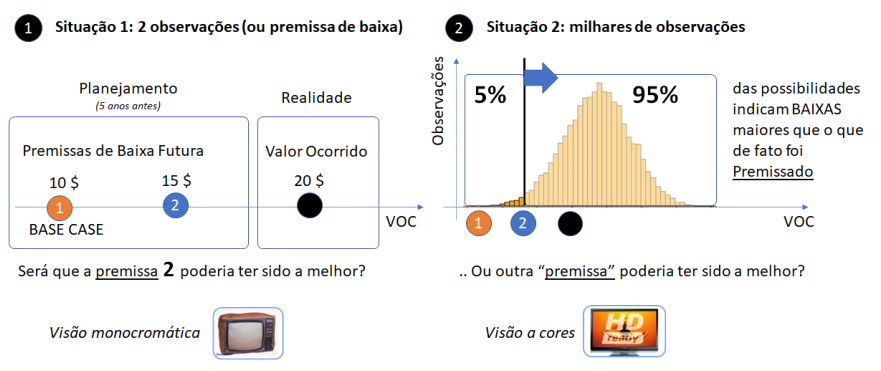

Em outra perspectiva, e colocando um exemplo teórico que elucida as dificuldades que um analista pode ter no momento de decidir por um ou outro valor futuro de Base de Remuneração Regulatória, toda e qualquer projeção deve estar precedida por questionamentos what if? (do inglês: e se?). Para um bom cálculo incerto, o analista necessariamente deve se questionar constantemente: “E se a desativação ocorrer diferente do que estão lhe contando?”; “E se a depreciação por questões regulamentares”; “E se a priorização do investimento (trade-off entre projetos) mudar?”. A seguir buscamos provocar uma reflexão no leitor com a pergunta “QUAIS DAS DUAS PREMISSAS DE BAIXA, DE UM TIPO DE UNIDADE DE CADASTRO, FOI A MAIS ASSERTADA?”, exemplificada em 2 situações: (1) com uma pobre identificação de observações; e outra (2) com um gama de milhares ou milhões de cenários.

Figura 4: Variáveis Processo de Baixas

Fonte: Acervo do Autor

Observa-se que tomar decisões usando a Situação 2, certamente você terá mais controle no resultado, e poderá antever situações ou premissas que na situação 1 você não tinha ideia. “Assistir uma TV à Cores é bem melhor que TV Monocromática”!

7. PROPOSTA

Desenvolver uma ferramenta usando métodos estatísticos mesclado ao universo d ciência de dados para fazer uma estimativa provável (predição) do impacto das baixas contábeis no valor da Base de Remuneração Regulatória, dados parâmetros técnicos mínimos.

8. FUNDAMENTAÇÃO TEÓRICA

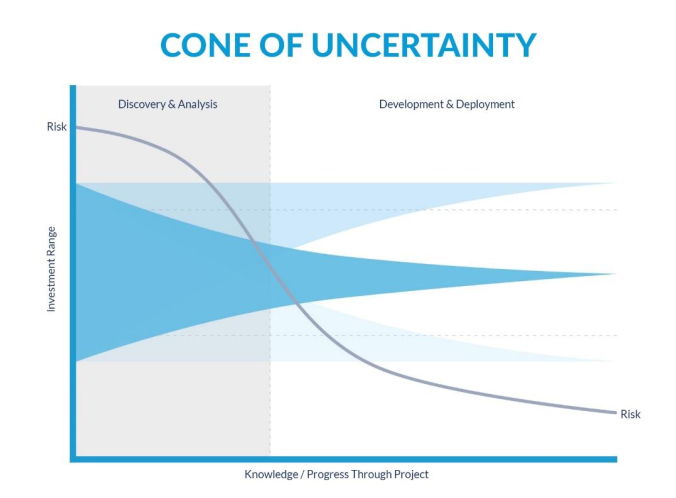

I. Cone da Incerteza

Usado bastante em projetos, o Cone da Incerteza é uma abordagem que utiliza em sua essência medir o quanto de conhecimento existe em relação ao desenvolvimento em questão. Usa-se esta ferramenta estatística para medir estimativas e variáveis para determinada situação em que o cenário de não previsibilidade de eventos é predominante.

A abordagem do Cone da Incerteza consiste em medir eventos conhecidos e desenvolvidos num projeto e à medida que vamos conhecendo melhor o caminho a ser percorrido, sabe-se que as incertezas diminuem, portanto, a variabilidade da incerteza que incialmente pode-se ser estimada em quatro vezes mais, ou quatro vezes menos, ao longo do desenvolvimento esta faixa de incerteza acaba diminuindo, permitindo-se assim, delimitar faixas de acuracidade, melhorando desta forma a estimativa de probabilidade do comportamento dos eventos.

Busca-se através desta abordagem, a maximização entre: (1) a diminuição da percepção de risco de retorno do investimento; (2) aumento do conhecimento através das observações geradas; e (3) assertividade temporal (na medida que “caminhamos no tempo”) nas decisões.

Ao aplicar esta metodologia objetiva-se uma transladação de acuracidade de eventos estimados para maior previsibilidade de possibilidades ao longo da realização do projeto baseado nos acontecimentos vividos. Portanto, afirma-se que para melhor assertividade, ao estimar incertezas, é fundamental olhar para o passado e absorver percepções qualitativas dos especialistas, e através dele, minimizar elementos de incertezas no futuro.

Por fim, o Cone da Incerteza é bastante utilizado para projetos ágeis que atualmente estão dominando o mercado de trabalho, muito usado na ferramenta de gestão “SCRUM”, mas não se limita apenas a esse uso. Por ser uma teoria de bastante amplitude permite-se adaptações, buscando sempre melhorar as estimativas e diminuir eventos não conhecidos, por maior segurança baseado nos acontecimentos vividos durante desenvolvimento da criação do produto/serviço.

Figura 5: Ilustração Cone da Incerteza

II. Lógica Nebulosa

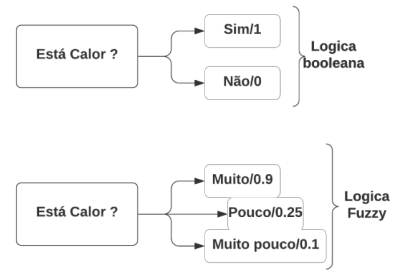

A lógica Fuzzy é uma extensão da lógica clássica, que é usada para especificar as propriedades de dois sistemas como conteúdo de informação incerta. A base do modelo computacional predominante da atualidade, onde um bit é 0 ou 1, verdadeiro ou falso, ligado ou desligado.

- A primeira ocorrência da expressão “lógica fuzzy” (nebulosa) para ser utilizada com base na teoria de conjuntos fuzzy foi usada no artigo Fuzzy Sets (ZADEH, 1965).

Onde um modelo matemático mais flexível, chamado de Lógica Nebulosa (ou Lógica Fuzzy), em que as coisas deixam simplesmente de ser ou não ser, elas possuem grau de pertencimento.

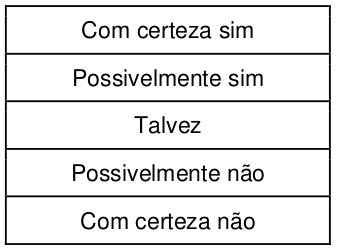

Lógica Fuzzy é um método de raciocínio que se assemelha ao raciocínio humano. Essa abordagem é semelhante há como os humanos realizam a tomada de decisões. E envolve todas as possibilidades intermediárias entre SIM e NÃO.

Figura 6: Bloco Lógicos

Fonte: Acervo do Autor

O bloco de lógica convencional do chapéu de um computador tem entrada precisa e produz uma saída definitiva como verdadeiro ou falso, o que equivale a SIM de um ser humano ou NÃO. A lógica Fuzzy foi proposto Lotfi Zadeh que observou que, ao contrário dos computadores, os humanos têm uma gama diferente de possibilidades entre SIM e NÃO, tais como:

Tabela 3: Gama de Possibilidades

Fonte: Acervo do Autor

A lógica Fuzzy trabalha nos níveis de possibilidades de entrada para alcançar uma saída definida, a implementação desta lógica:

- Ele pode ser implementado em sistemas com diferentes tamanhos e recursos, como microcontroladores, grandes sistemas em rede ou baseados em estações de trabalho.

- Além disso, pode ser implementado em hardware, software ou uma combinação de ambos.

É uma lógica oportunizadora de diversos cenários de avaliação, consistente com a ideia de trabalhar com situações ainda de cenários desconhecidos permitindo amplas possibilidades de convergência de resultados, admitindo diversas variáveis em sua elaboração. Lembramos que esta mesma lógica foi usada quando da criação dos chamados “clusters”, ou grupos de concessionárias que foram assemelhadas pelo órgão regulador na concepção da atualização do Proret2 2.3 em novembro de 2015. Nesse módulo de predição das baixas vamos iniciar o programa com a exploração da lógica nebulosa combinada com outra ferramenta estatística para criar os cenários, e as quantidades de possibilidades de cenário para sumariamente validar a população de dados em análise conforme limitação dada com a inserção dos dados pelo usuário.

III. Princípio de Pareto

- Vilfredo Pareto foi um sociólogo e economista italiano que introduziu um termo bastante conhecido hoje, o “Princípio de Pareto”. Em 1892, Pareto escreveu um artigo demonstrando que 80% das terras italianas pertenciam a 20% da população. Posteriormente, observando vagens que cresciam em seu jardim, percebeu que cerca de 20% das vagens continham 80% das sementes.

- À partir dessas observações que ele definiu o princípio, que é uma rule of thumb, algo que se prova mais por conta da experiência que comprovações científicas, e que não é extremamente preciso (por exemplo, a regra pode variar com números próximos aos definidos, como 81% — 19%, etc).

- Apesar disso, o princípio de Pareto é a primeira Lei de Potência conhecida, e está empiricamente relacionado com diversos fenômenos naturais ou não. Alguns exemplos:

-

20% da população mundial controla 82,7% da renda

20% dos atletas participam de 80% das grandes competições e destes, cerca de 20% ganham 80% das premiações

Cerca de 20% dos perigos são responsáveis por 80% dos acidentes

Cerca de 20% das postagens geram 80% do tráfego e garantem maior engajamento. (Rodrigues, 2018)

Sabe-se que o Princípio de Pareto é amplamente difundido para realização de análises para determinar relevância de determinada amostra conforme importância em relação ao impacto. A área de logística usa muito essa análise para gestão de seus estoques, todavia, percebe-se que várias áreas das organizações aplicam esse fundamento para auxiliar o processo de decisão de seus gestores.

Para o objetivo deste trabalho espera-se que o Princípio de Pareto associado ao item antecessor a este, sejam a combinação ideal para apuração, consolidação e priorização dos dados. Tanto a Lógica nebulosa quanto o Princípio de Pareto ajudarão dar forma aos cenários de possibilidades até a construção da ferramenta proposta como solução a questão central deste artigo.

IV. Princípio de Pareto

- Backtracking é um algoritmo geral para encontrar todas (ou algumas) soluções para alguns problemas computacionais, que cria candidatos às soluções de forma incremental (CIVICIOGLU, 2013).

Assim que determina que um candidato não pode levar a uma solução completa válida, ele abandona esse candidato parcial e “retrocede” (retornar ao nível superior) e redefine para o estado do nível superior para que o processo de pesquisa possa continuar a explorar o próximo ramo.

Figura 7: Exemplo de Backtracking

Fonte: Acervo do Autor

Backtracking é um refinamento do algoritmo de busca por força bruta (ou enumeração exaustiva), no qual boa parte das soluções podem ser eliminadas sem serem explicitamente examinadas. Se existir mais de uma decisão disponível para cada uma das n decisões, a busca exaustiva será exponencial. A eficiência da estratégia depende da possibilidade de limitar a busca, ou seja, podar a árvore eliminando os ramos que não levam à solução desejada.

Propriedades e aplicações:

Sem repetição e conclusão: é um método de geração sistemático que evita repetições e perder qualquer solução correta possível. Esta propriedade o torna ideal para resolver problemas combinatórios, como combinação e permutação, que nos obriga a enumerar todas as soluções possíveis.

Poda de pesquisa: Como a solução final é construída de forma incremental, no processo de trabalhar com soluções parciais, podemos avaliar a solução parcial e podar ramos que nunca levariam à solução completa aceitável: ou é uma configuração inválida ou é pior do que solução completa possível conhecida.

Backtracking é o algoritmo mais comum para resolver o problema de satisfação de restrição (constraint satisfaction problems (CSPs) são questões matemáticas definidas como um conjunto de objetos cujo estado deve satisfazer uma série de restrições ou limitações como o problema de colorir mapas, Sudoku, Palavras cruzadas e muitos outros quebra-cabeças lógicos.

Usa-se este refinamento algorítmico para delimitar conforme dados inseridos pelo usuário a criação de cenários para a ferramenta. Backtracking foi a melhor opção encontrada para restringir e promover a convergência de resultados com a finalidade de manter o caminho a ser percorrido por cenários sabidamente incertos e com muita variabilidade em suas construções, juntamente com métodos estatísticos que começam a estruturar até aqui respostas para questões de alta complexidade.

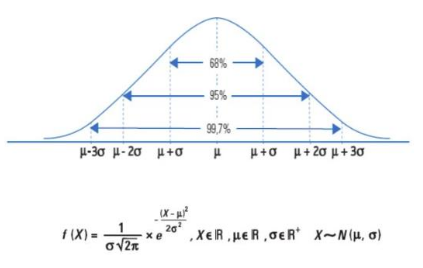

V. Teorema do Limite Central

-

“O Teorema Central do Limite (TCL) é um dos teoremas mais importante dentro da Estatística e Probabilidade. É um teorema limite que foi considerado como “Central” pelo matemático húngaro George Pólya.

É o teorema fundamental da probabilidade e estatística, muitos outros teoremas dependem dele. O Teorema Central do Limite estabelece que a distribuição da soma (ou média) de um grande número de variáveis aleatórias independentes e identicamente distribuídas (i.i.d.) será aproximadamente normal, independentemente da distribuição subjacente (dessas variáveis) …”(Zibetti, 2021)

Este teorema descreve a distribuição da média de uma amostra aleatória de uma população com variância finita. Se o tamanho da amostra for suficientemente grande, a distribuição da média se aproxima da distribuição normal, se a distribuição for fortemente assimétrica então será necessária uma amostra maior.

Figura 8: Distribuição Normal

Fonte: https://slideplayer.com.br/slide/1240420/

Para inferência estatística o teorema do limite central tem grande utilidade para estimar parâmetros como média populacional ou o desvio padrão da média populacional a partir da amostra aleatória da população. De forma mais empírica pode-se imaginar que ao se distanciar da média, a probabilidade da ocorrência de algo diminui ou seja pode-se entender que é mais provável a ocorrência de um evento que se encontra próximo à média do que um evento que se encontra nas extremidades.

Com os conceitos do Teorema do Limite central pretende-se usar juntamente com o método de sorteio realizar análises de mais de um cenário para a variável TUC promovendo conflução pela média dos valores contidos nas bases de dados a serem analisadas pela solução desenhada. Objetiva-se a possibilidade de elaboração de cenários com diversidade nas análises considerando o preceito legal de poder realizar baixas por ativos similares, quando o ativo envolvido no processo, não mais haver quantidade necessária para todo o volume a ser retirado de sua Base de Remuneração Regulatória – BRR.

VI. Método de Monte Carlo

Desenvolvida pelos matemáticos Stanislaw Ulam e John von Neumann em 1940, durante o projeto Manhattan referente ao programa de bombas nucleares dos Estados Unidos, o nome deste método surge devido a sugestão de um colega de sobre a história de um tio de Ulam. Resumindo, o ato de agir sem pensar de determinada pessoa, serviu para dar nome a um método de cálculo de riscos, ironicamente. Evan e Olson (1998), definem o método da seguinte forma:

- A simulação de Monte Carlo, é um experimento amostral, que tem como objetivo quantificar a probabilidade de possíveis resultados da variável de interesse, embasada em uma ou mais variáveis de entrada, que se comportam de forma probabilística de acordo com alguma distribuição estipulada. (EVANS e OLSON, 1998)

Vislumbra-se no contexto acima uma visão holística sobre o método, uma boa forma de compreender o alcance da simulação de Monte Carlo, atualmente muito difundida em resoluções de impasses considerados de grande complexidade para organizações, pessoas e instituições. Na busca de obter a melhor definição para esta ferramenta temos a seguinte declaração:

- A simulação de Monte Carlo é um processo de amostragem que tem como objetivo permitir a observação do desempenho de uma variável de interesse em razão do comportamento de variáveis que carregam elementos de incerteza. (Buratto, 2002)

A consideração desses elementos de incertezas traz para o debate a caracterização de que podemos resolver qualquer questão quando usamos esta metodologia, todavia, em nome dos amplos vieses de definições, conclui-se a definição da ferramenta no sentido de acatar Law e Kelton (200) em sua acepção:

-

A simulação de Monte Carlo é utilizada para solucionar problemas estocásticos, através da utilização de números aleatórios, partir desse mecanismo que serão estimadas as distribuições das variáveis de interesse, tomando por base as premissas e as distribuições associadas às variáveis de entrada, bem como a inter-relação entre as mesmas.

Um algoritmo aritmético gerador de números pseudo-aleatórios deve satisfazer as seguintes condições:

- Os números produzidos devem parecer distribuídos conforme distribuição de probabilidade uniforme em determinado intervalo;

- Deve ser rápido na geração e consumir pouca memória;

- Deve propiciar a reprodutibilidade da sequência gerada. (Law e Kelton, 2000);

Desde sua descoberta essa ferramenta é explorada para as mais complexas análises, inclusive é parte da solução proposta por este artigo, ao considerar que se delineou o problema, gerou-se valores aleatórios para oscilações da questão levantada, se preencheu variações com valores, para encontrar resultado e se indicou soluções possíveis para a problemática apresentada.

9. METODOLOGIA

I. Desenvolvimento do Projeto

Para desenvolvimento foi adotada a linguagem de programação Python que possui estruturas de manipulação de dados em alto nível por meio de simples abordagens, facilitando a aplicação do paradigma de orientação a objetos.

O Python é amplamente usado para Big Data, tem se destacado com linguagem de programação na área de Inteligência Artificial. Esta linguagem também tem sido apontada como boa opção de para a área de inteligência artificial (IA), sendo a principal utilizada por muitos cientistas de dados. Durante anos, acadêmicos e pesquisadores particulares utilizaram MATLAB para pesquisa científica, mas o cenário começou a mudar com o lançamento de mecanismos numéricos do Python, como Numpy e Pandas. Além de lidar com dados tabulares, matriciais e estatísticos, e suportar computação paralela.

Por fim, segundo (SILVA et al., 2013) utilizamos do Python oferecido na manipulação de funções e de arquivos, visão corroborada por (ROSSUM; DRAKE, 2017 a e b), que cita ainda, outros exemplos, como a extensa quantidade de bibliotecas disponíveis, por exemplo, o Pandas, utilizado neste projeto para manipulação dos dados e a Numpy/SciPy para a manipulação estatística.

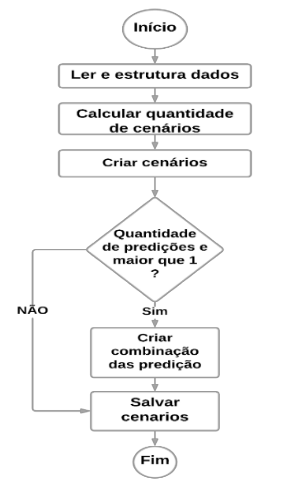

II. Estruturação do Projeto

O projeto de predição de baixas é estruturado em cinco macroprocessos, esses têm a finalidade de organizar o código com base nas suas características. O fluxograma das iterações dos macroprocessos descrito na figura abaixo:

Figura 9: Fluxograma predição de baixas

Fonte: Acervo do Autor

Onde:

- Ler e estruturar dados: Coleta dos parâmetros do usuário, coleta dos dados no banco de dados é a estruturação dos dados;

- Calcular quantidade de cenários: Calcula a quantidade de cenários a serem criados com base nos parâmetros estabelecidos pelo usuário e as características dos dados contidos na base;

- Criar cenários: Criar de forma recursiva cenários que atendam aos parâmetros citados pelo usuário;

- Criar combinação das predições: Cria um conjunto de cenários constituídos das combinações entre as predições especificadas pelo analista; e

- Salvar cenários: Salvar cenários, criar os gráficos de frequência e boxplot.

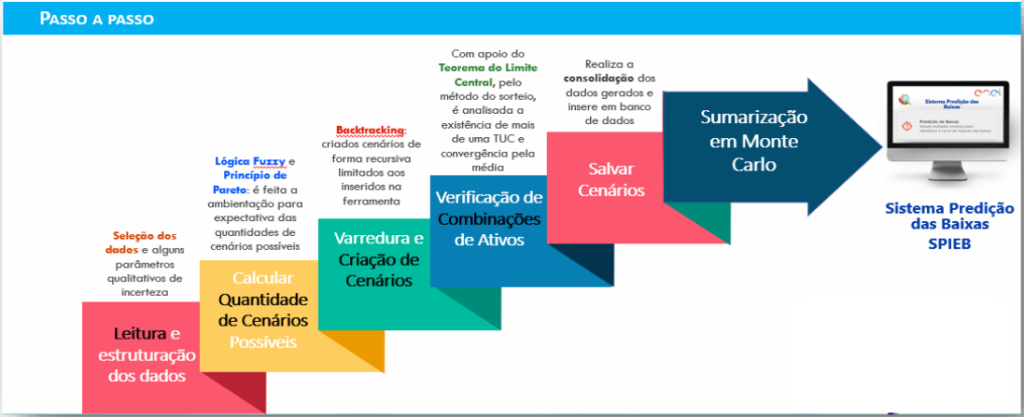

Realizado detalhamento do que cada parâmetro de informação significa, e com o intuito cristalizar o entendimento do leitor de forma concreta, montamos a figura abaixo para ilustrar de forma simplificada como está estruturado a cadeia de processos do sistema.

Figura 10: Passo a Passo Sistema

Fonte: Acervo dos Autores

III. Parâmetros de entrada

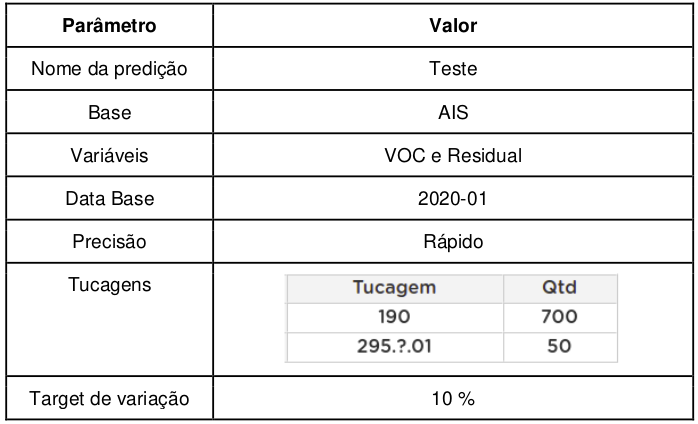

Segue o exemplo dois parâmetros de entrada da predição de baixa de baixas:

Tabela 4: Parâmetros de entrada

Fonte: Acervo dos Autores

Onde:

Nome da predição: Nome de identificação da flexão;

Base: Identifica de qual base de dados será feita a extração de dados;

Variáveis: Informa quais variáveis serão utilizadas para criação do gráfico de frequência e Boxplot;

Data Base: seleciona a data base dos dados que serão extraídos do banco de dados;

Precisão: É parâmetro simplificador criado para diminuir o número de parâmetros, pois a quantidade de cenários que podem ser criados depende da quantidade de baixa e a quantidade que existe na base de dados. Sendo 3 modos que são o (Rápido: Gera rapidamente um conjunto de cenários com o tamanho e precisão razoáveis, para uma análise macro. Moderado: gera em um tempo moderado, um conjunto de cenários com o tamanho e precisão razoáveis, para uma análise estatística mais apurada. Preciso: gerar em um tempo longo um conjunto de cenários com o tamanho e precisão máxima, para uma análise estatística completa.);

Tucagens: Seleciona as trucagens e as quantidades a serem baixadas para elas, e;

Target de variação: Tem a finalidade de flexibilizar a quantidade de baixas especificadas no parâmetro do Tubagens.

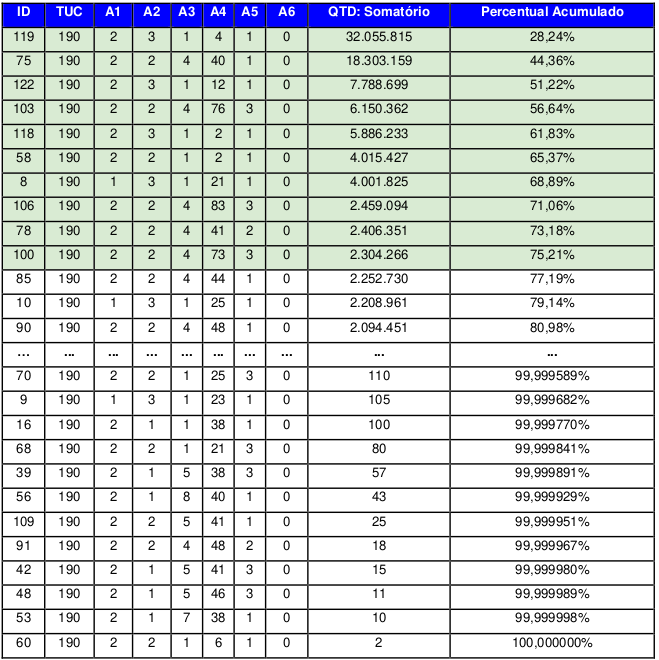

IV. Cálculo de Cenários

A primeira etapa do cálculo da quantidade é feita através do agrupamento das tucagens desejadas, após esta etapa, pega-se o total de quantidade de bens inseridos e divide pelo total elementos na base. Na tabela 6 temos exemplo feito com a TUC 190, onde o agrupamento resultou em uma tabela de 130 linhas.

Tabela 5: Agrupamento por tucagem

Fonte: Acervo do Autor

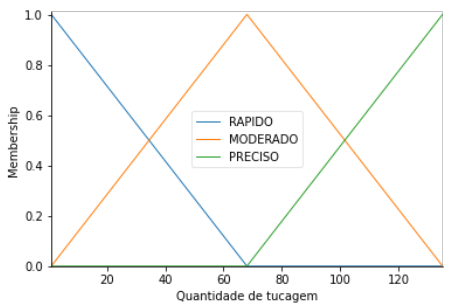

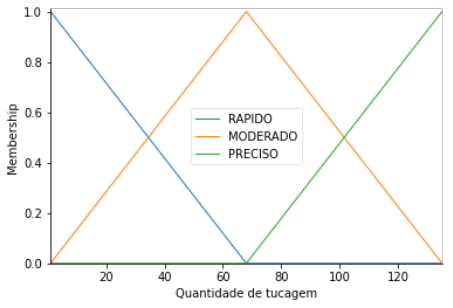

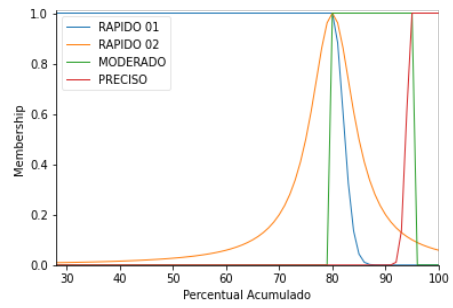

Para a criação do cenário foi selecionado 10 tucagens, que representa mais de 75% dos dados. Essa seleção foi feita através de lógica Fuzzy, que no caso leva em conta o tamanho da base e o modo de execução definido pelo usuário. A função Fuzzy utilizada nesse processo estão nas figuras esquematizadas nas figuras abaixo:

Figura 11: Função Fuzzy quantidade de tucagens.

Fonte: Acervo do Autor

Figura 12: Função Fuzzy precisão.

Fonte: Acervo do Autor

Figura 13: Função Fuzzy percentual acumulado.

Fonte: Acervo do Autor

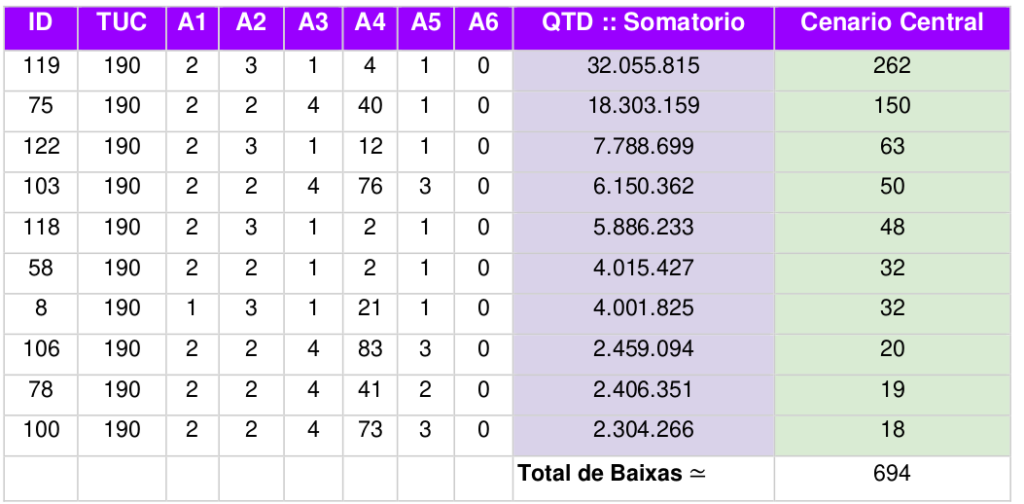

V. Cenário central

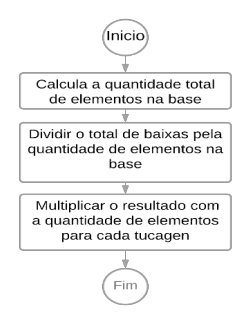

O cenário central é o conjunto de valores referenciais, calculados levando em consideração a relação do valor total de baixas e a quantidade de elementos em cada tucagem. Este cenário tem o intuito de direcionar a criação de cenários para um intervalo factível, pois a característica quantitativa de cada tucagem é mantida independentemente do valor total de baixar. O processo de criação do cenário central é descrito na figura 11 e exemplo na tabela 6.

Figura 14: Fluxograma do cenário Central

Fonte: Acervo do Autor

Tabela 6: Cenário central TUC 190.

Fonte: Acervo do Autor

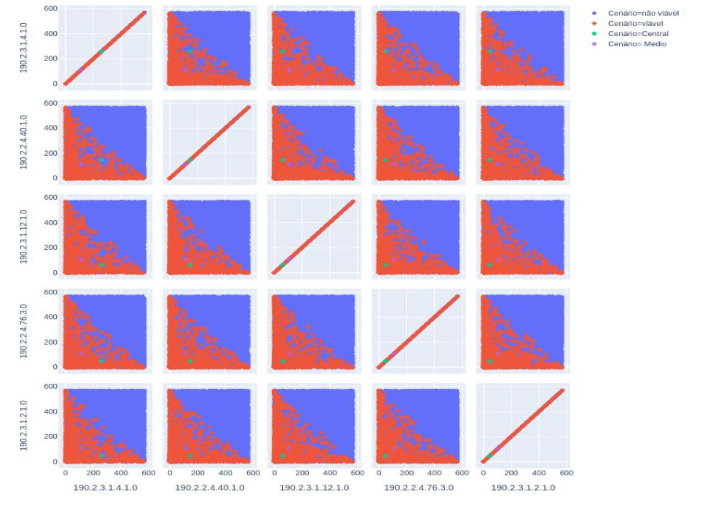

Através de uma simulação randomizado com 10.000 cenários criados, utilizado as 5 primeiras tucagem da tabela 4 na simulação, foi feita baixada no intervalo de 470 até 575 com esses dados foram calculados o cenário médio onde o este cenário e distância média os cenários factíveis contidos na simulação. A relação entre o cenário central e o cenário factível é demonstrado na figura 15.

Figura 15: Matriz de dispersão.

Fonte: Acervo do Autor

O erro absoluto entre o cenário central e o cenário médio é de 1,64%, os valores de baixa para os cenários médio e central estão na Tabela 7.

Tabela 7: Cenários da simulação TUC 190.

Fonte: Acervo do Autor

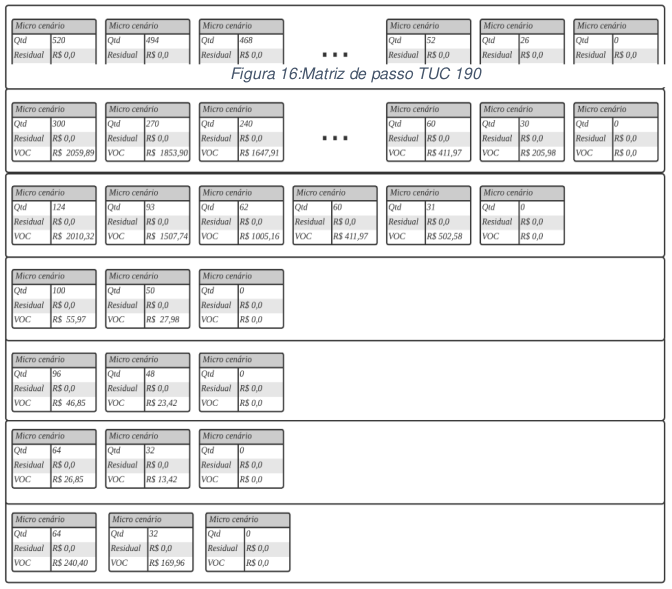

VI. Matriz de Passos

Com o cenário central também é calculado um conjunto de microcenários de baixas para cada tucagem. A quantidade de microcenários para cada conjunto é diretamente proporcional ao valor calculado no cenário central para a respectiva tucagem.

A distribuição das quantidades de baixas para cada microcenário é calculada através de uma progressão aritmética utilizando o cenário central da tucagem e a variável passo, descrito na equação abaixo:

𝑞𝑡𝑑𝑛 = 𝑞𝑑𝑡1 + (𝑛 − 1) ⋅ 𝑟

Onde:

- 𝑞𝑡𝑑𝑛 é o dobro do valor do cenário central;

- 𝑟 é a divisão do valor do cenário central pelo passo;

O valor do passo é óbito através de uma função Fuzzy, onde a matriz de passo é constituída pelos conjuntos de microcenários de baixas de cada tucagem. Sendo assim, ela caracteriza uma matriz dinâmica, onde as colunas são os microcenários de baixas e as linhas, a identificação de qual tucagem o conjunto pertence.

Figura 16: Matriz de passo TUC 190

Fonte: Acervo do Autor

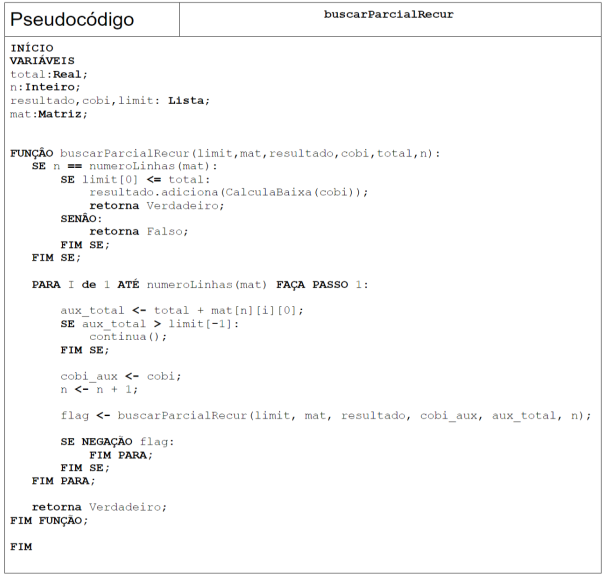

VII. Algoritmo de criação de cenários

Para criar os cenários foi feito um algoritmo do tipo Backtracking, descrito no pseudocódigo na abaixo, onde: limit é o intervalo de quantidade de baixas permitido; mat é a matriz de passos.

Figura 17: Pseudocódigo.

Fonte: Acervo do Autor

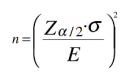

VIII. Gerador de Combinações

Com os cenários criados para cada TUC é criado um de conjunto amostra randomizada com as combinações dos cenários das TUC’s. O cálculo do tamanho da amostra é da dados por:

Onde:

- n é o tamanho da amostra;

- 𝑍𝛼/2 é o valor crítico que corresponde ao grau de confiança desejado;

- 𝜎 é o desvio-padrão populacional; e

- E é a margem de erro ou erro máximo de estimativa.

10. RESULTADO

Após aplicação da metodologia exposta acima, realizou-se testes para verificar possibilidades de relatórios levantados pelo desafio intrincado nas páginas iniciais deste trabalho. Desenvolveu-se ferramenta usando ferramenta a linguagem de programação Phyton como meio de solução e nomeou-se como Sistema de Predição das Baixas – SPB. Conforme figura abaixo:

Figura 18: Aplicação Sistema de Predição das Baixas

Fonte: Acervo do Autor

Usando a ferramenta desenvolvida é possível estimar o impacto das baixas na BRR, apenas inserido poucos dados na solução apresentada. Para testar o instrumento desenvolvido aplicamos o seguinte case:

“Sabendo que a empresa baixará aproximadamente 700 postes até a próxima revisão tarifária, qual deverá ser o impacto em R$ proveniente dessas baixas a ser considerado na projeção de BRR que fazemos hoje?”

Inserindo no programa a quantidade 700 e no parâmetro TUC informou-se 255, obtivemos o seguinte desfecho:

Figura 19: Resultado da Predição Simulada

Fonte: Acervo do Autor

O sistema gerou para resolver a questão aproximadamente 2 milhões de cenários usando a metodologia apresentada no desenvolvimento deste artigo. Respondeu à questão inclusive nos mostrando histograma, e particularizando para a probabilidade do ponto de 95% do gráfico, percebe-se que no mínimo para este cenário o impacto em R$ seria de pouco mais de R$90 mil e o máximo para a mesma situação o valor chegaria a pouco mais de R$ 252 mil.

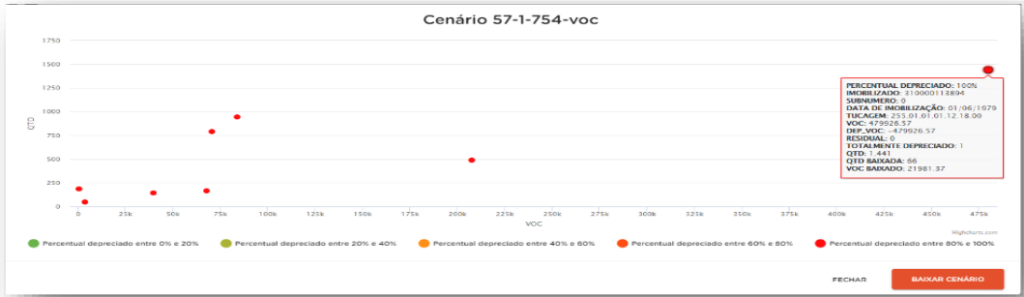

Ainda é proporcionado ao usuário da solução aprofundamento nas análises através de gráfico com maiores minucias de informações para aquela faixa de variação combinada pelo programa e com isso gera-se gráficos de dispersão para o ponto com o intuito de viabilizar uma análise consistente, como verifica-se na figura abaixo:

Figura 24: Gráfico de dispersão para cenário gerado

Fonte: Acervo do Autor

11. CONCLUSÃO

Durante a elaboração deste trabalho desafiamos a complexidade de realizar predição do impacto do processo de baixas em cenários incertos e com múltiplas variáveis, buscando consolidar tais simulações em modelos estatísticos que simplificassem a apresentação e entendimento dos resultados. Para tanto, usamos o método de Monte Carlo como abordagem estatística na consolidação final dos resultados, e uma gama de teoremas e técnicas matemáticas que possibilitassem de forma ágil “varrer” todas as opções de baixas de um determinado Ativo, guardando sempre o conceito de representatividade estatística da amostra.

Entende-se ter alcançado o objetivo do desafio proposto, e hoje, dispõem-se de uma ferramenta elaborada com razoável grau probabilístico, lançando “luz ao horizonte de um mundo incerto”, antes mesmo, estimado por vezes, simploriamente e precariamente.

Espera-se minimizar o tempo de elaboração de projeções dos valores das baixas, bem como, propiciar análises técnicas nas ordens de desativação, além de buscar mais assertividade no cálculo da Base de Remuneração Regulatória futura. A ferramenta está em uso atualmente no grupo Enel, mostrou-se viável e coerente à dinâmica de altas e baixas dos Ativos, bem como alinhada às necessidades de planejamento orçamentário pela área de Regulação.

Buscou-se ir, adicionalmente, no detalhe das premissas e dos cálculos necessários para estas projeções, mesmo que tenha sido necessário adentrar na complexidade dos algoritmos intrínsecos à modulação das incertezas, mas, atentando sempre, na incessante busca pela simplificação da evidência dos resultados com o uso do Método de Monte-Carlo. Ao final, a conclusões deveriam partir de evidências que pudessem ser vistas facilmente “por olhos de pessoas comuns”.

A possibilidade de combinação de TUC’s para realização dos cenários de predição viabiliza avanço e desbrava oportunidades de análises ainda incipientes, ou não existentes. Apostar em desenvolvimento de ferramentas tecnológicas como essa, faz as empresas se diferenciarem na busca de melhor eficiência, qualidade e otimização.

Por fim, destaca-se a importância da divulgação e constante uso dessa nova forma de projetar o impacto econômico e financeiro oriundo da atividade de baixa de ativo de uma maneira melhor e, mais confiável. Acredita-se que com essa ferramenta aumentemos também o “nível” de discussão com o Setor e o Regulador em matéria de valoração de Base de Remuneração dos Ativos, além de trazer para um business (o de Distribuição de Energia) – que na sua gênese de constituição é averso à risco – uma maior percepção e antecipação do grau de sustentabilidade econômico- financeiro da concessão.

REFERÊNCIAS

OLIVEIRA, A. Sampaio. Método MonteCarlo para avaliação equilíbrio Tarifário investimentos Price-Cap. EGAESE, 2019

SILVA, R. M. A. et al. A Python/C library for bound-constrained global optimization with continuous GRASP. Optimization Letters, v. 7, n. 5, p. 967–984, 2013.

ZADEH, L. A. Fuzzy sets. Information and Control, v. 8, p. 338- 353, 1965. CIVICIOGLU, Pinar. Backtracking search optimization algorithm for numerical optimization problems. Applied Mathematics and computation, v. 219, n. 15, p. 8121- 8144, 2013.

KAWANO, Alexandre; DE PAIVA, José Luís. Teorema do Limite Central. 2020.

ROSSUM, G. VAN; DRAKE, F. L. The Python Library ReferencePython Software Foundation. [s.l: s.n.].

ROSSUM, G. VAN; DRAKE, F. L. Python TutorialPython Software Foundation. [s.l: s.n.].

SILVA, R. M. A. et al. A Python/C library for bound-constrained global optimization with continuous GRASP. Optimization Letters, v. 7, n. 5, p. 967–984, 2013. Manual de Contabilidade do Setor Elétrico, versão 2015, RN 605, de 11 de março de 2014.

Manual de Controle Patrimonial do Setor Elétrico, RN 674, de 11 de agosto de 2015.

Submódulo 2.3 – Base de Remuneração Regulatória, RN 686, de 23 de novembro de 2015.

EVANS, J. R., OLSON, D. L. Introduction to simulation and risk analysis. New Jersey: Prentice Hall, 1998.

BURATTO, M. V. M. V.; Construção e Avaliação de um Modelo de Simulação de Monte Carlo para Analisar a Capacidade de Pagamento das Empresas em Financiamentos de Longo Prazo, Dissertação de Mestrado – Universidade Federal do Rio Grande do Sul (2002).

LAW, A.M. et KELTON, W.D. Simulation Modeling and Analysis. 3a. ed. New York: McGraw-Hill: 2000.